Entrenar redes neuronales para realizar tareas, como reconocer imágenes o navegar en coches autónomos, podría algún día requerir menos potencia de cómputo y hardware gracias a un nuevo dispositivo neuronal artificial desarrollado por investigadores de la Universidad de California en San Diego. El dispositivo puede ejecutar cálculos de redes neuronales utilizando de 100 a 1000 veces menos energía y área que el hardware existente basado en CMOS (semiconductor complementario de óxido metálico). Los investigadores informan sobre su trabajo en un artículo publicado hoy en Nature Nanotechnology.

Las redes neuronales son una serie de capas conectadas de neuronas artificiales, donde la salida de una capa proporciona la entrada a la siguiente. La generación de esa entrada se realiza aplicando un cálculo matemático llamado función de activación no lineal. Esta es una parte fundamental del funcionamiento de una red neuronal. Pero la aplicación de esta función requiere mucha potencia informática y circuitos porque implica la transferencia de datos entre dos unidades separadas: la memoria y un procesador externo. Ahora, los investigadores de UC San Diego han desarrollado un dispositivo de tamaño nanométrico que puede llevar a cabo de manera eficiente la función de activación.

El dispositivo neuronal artificial implementa una de las funciones de activación más comúnmente utilizadas en el entrenamiento de redes neuronales llamada unidad lineal rectificada

«Los cálculos de redes neuronales en hardware se vuelven cada vez más ineficientes a medida que los modelos de redes neuronales se hacen más grandes y complejos«, comenta Duygu Kuzum, profesor de ingeniería eléctrica e informática en la Escuela de Ingeniería UC San Diego Jacobs. «Desarrollamos un único dispositivo de neuronas artificiales a nanoescala que implementa estos cálculos en hardware de una manera muy eficiente en cuanto a área y energía«.

El nuevo estudio, dirigido por Kuzum y su estudiante de doctorado Sangheon Oh, se realizó en colaboración con el DOE Energy Frontier Research Center dirigido por el profesor de física de UC San Diego Ivan Schuller, enfocado en desarrollar implementaciones de hardware de redes neuronales artificiales energéticamente eficientes.

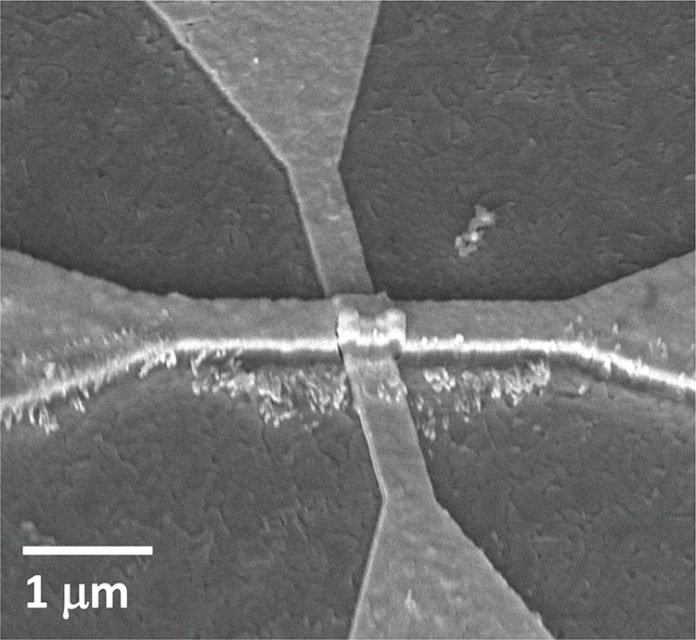

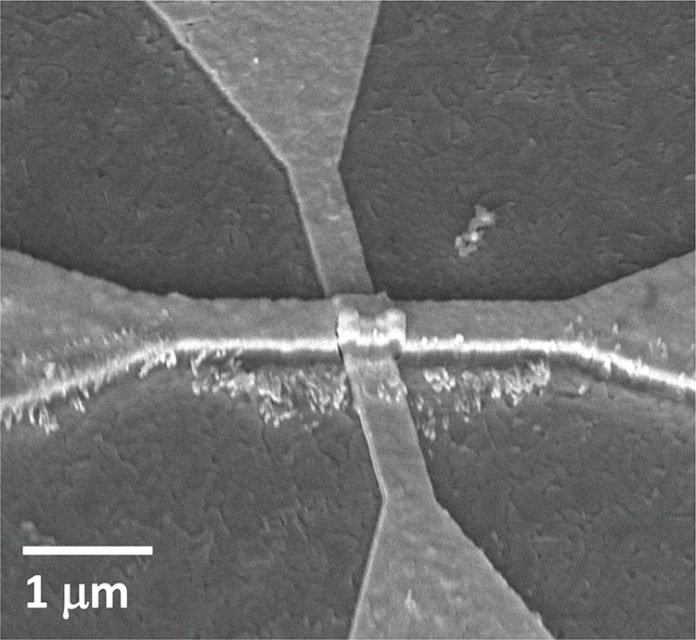

El dispositivo implementa una de las funciones de activación más comúnmente utilizadas en el entrenamiento de redes neuronales llamada unidad lineal rectificada. Lo particular de esta función es que necesita hardware que pueda sufrir un cambio gradual de resistencia para funcionar. Y eso es exactamente para lo que los investigadores de UC San Diego diseñaron su dispositivo: puede cambiar gradualmente de un estado aislante a uno conductor, y lo hace con la ayuda de un poco de calor.

Este interruptor es lo que se llama una transición de Mott. Tiene lugar en una capa de dióxido de vanadio de nanómetros de espesor. Sobre esta capa hay un calentador de nanocables hecho de titanio y oro. Cuando la corriente fluye a través del nanoalambre, la capa de dióxido de vanadio se calienta lentamente, provocando un cambio lento y controlado de aislante a conductor.

«Esta arquitectura de dispositivo es muy interesante e innovadora«, afirma Oh, primer autor del estudio. Por lo general, los materiales en una transición de Mott experimentan un cambio abrupto de aislante a conductor porque la corriente fluye directamente a través del material, explica. «En este caso, hacemos fluir corriente a través de un nanoalambre en la parte superior del material para calentarlo e inducir un cambio de resistencia muy gradual«.

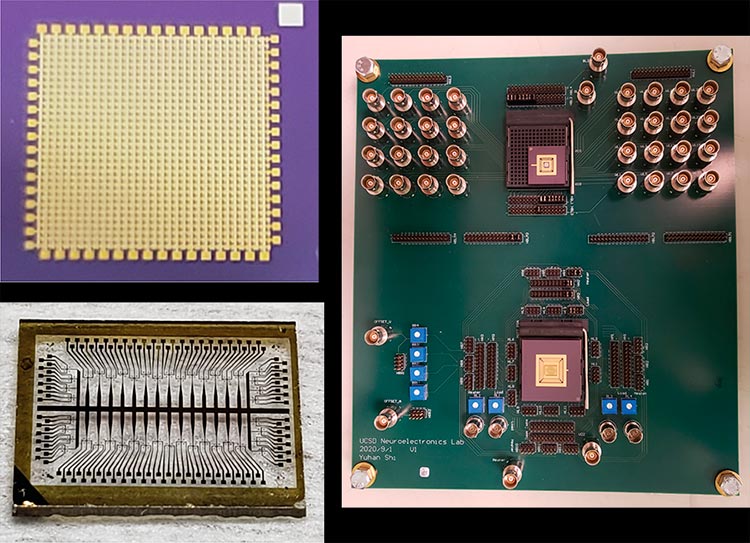

Para implementar el dispositivo, los investigadores primero fabricaron una serie de los llamados dispositivos de activación (o neuronas), junto con una serie de dispositivos sinápticos. Luego, integraron las dos matrices en una placa de circuito impreso personalizada y las conectaron para crear una versión de hardware de una red neuronal.

Los investigadores utilizaron la red para procesar una imagen, en este caso, de la Biblioteca Geisel en UC San Diego. La red realizó un tipo de procesamiento de imágenes llamado detección de bordes, que identifica los contornos o bordes de los objetos en una imagen. Este experimento demostró que el sistema de hardware integrado puede realizar operaciones de convolución, que son esenciales para muchos tipos de redes neuronales profundas. Una convolución es un operador matemático que transforma dos funciones f y g en una tercera función que en cierto sentido representa la magnitud en la que se superponen f y una versión trasladada e invertida de g.

Los investigadores aseguran que la tecnología podría ampliarse aún más para realizar tareas más complejas, como el reconocimiento facial y de objetos en automóviles autónomos. Con el interés y la colaboración de la industria, esto podría suceder, según señaló Kuzum.

«En este momento, esta es una prueba de concepto«, concluye Kuzum. «Es un sistema pequeño en el que sólo apilamos una capa de sinapsis con una capa de activación. Al apilar más de estas juntas, podríamos crear un sistema más complejo para diferentes aplicaciones«.

Fuente: UC San Diego.